西安十强互联网站建设公司创建网站怎么创

TIP 2024

贡献

1.首个提出面向显著性分割的深度图像压缩模型:通过比特分配方式控制局部失真,保留下游显著性目标检测所需关键信息,提升率-精度(R-A)性能。

2.适配下游网络的训练策略:能兼容各类下游SOD网络的训练策略,训练阶段无需辅助,针对两种重建质量等级训练压缩模型。

3.自适应比特分配机制:依据显著性概率分布反映像素重要性,经升余弦滚降(ACRD)生成逐像素权重引导比特分配。

4.实验:大量实验证明,该方法在十个下游显著性分割网络上实现最优R-A性能,相较现有先进深度图像压缩模型,平均节省10.34%比特率,充分验证方法有效性与优越性。

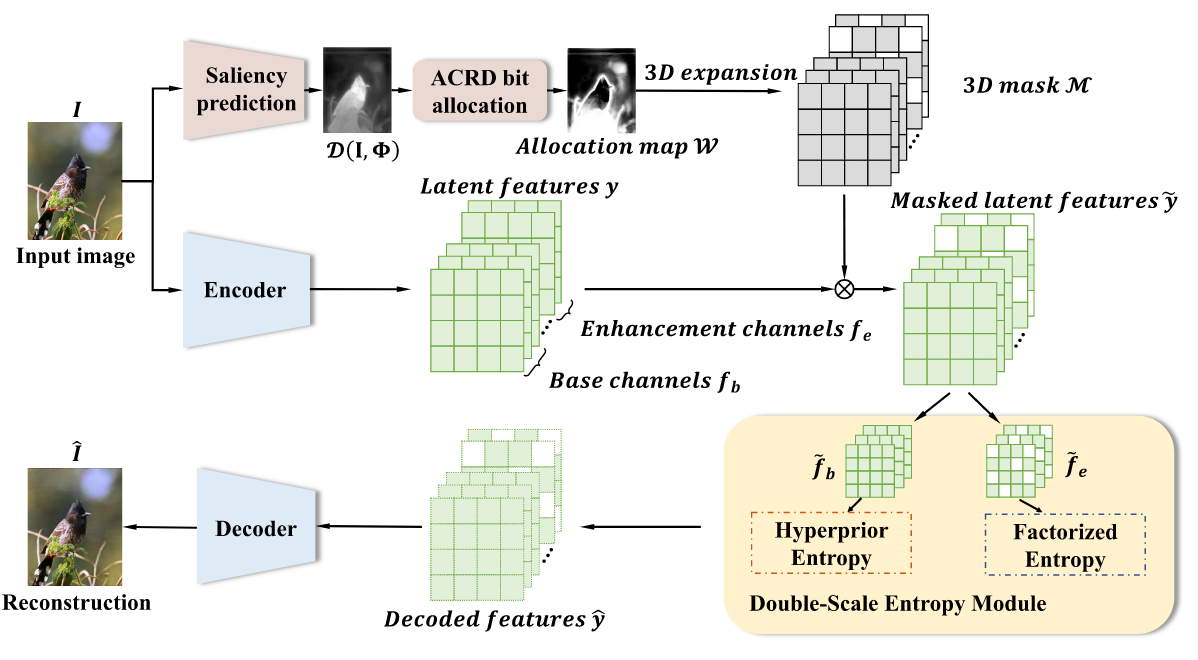

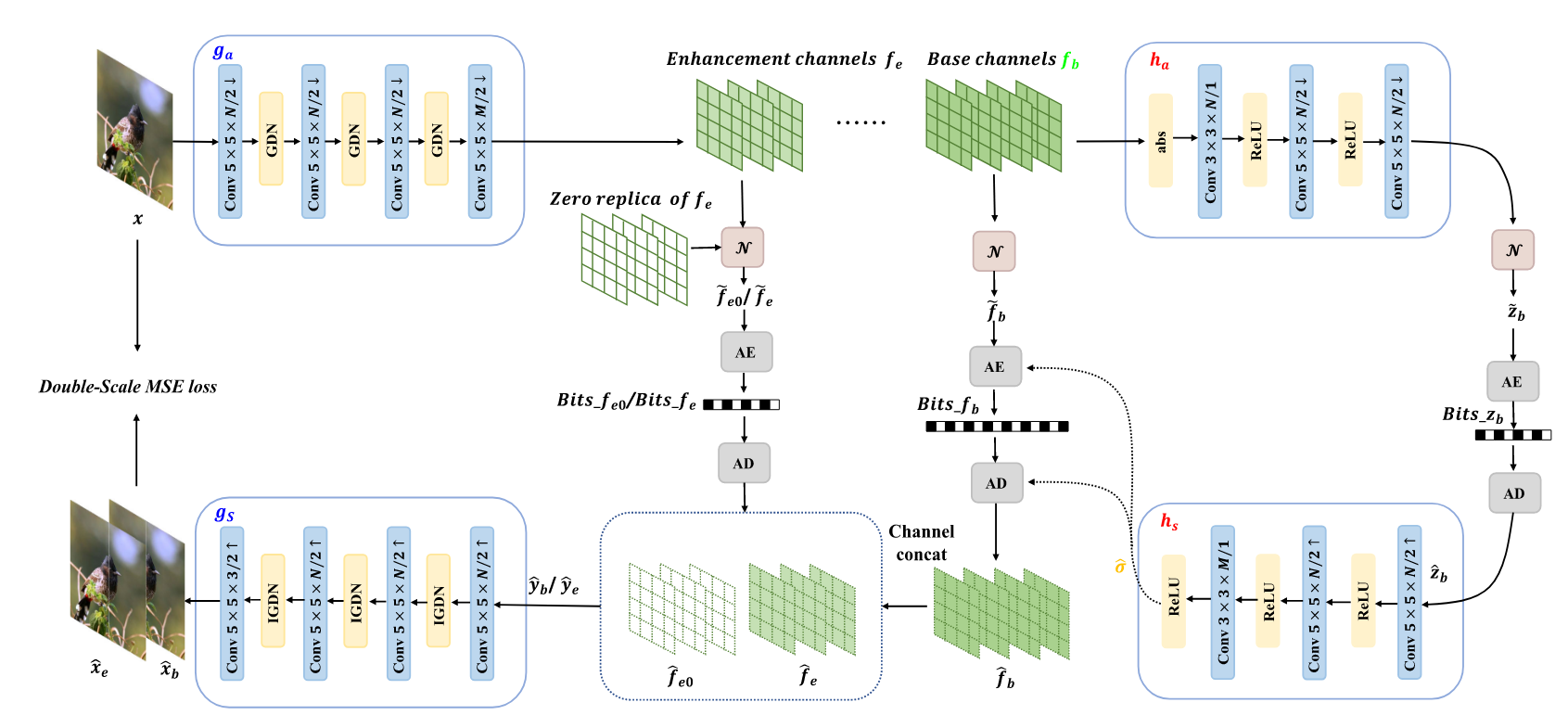

Pipeline

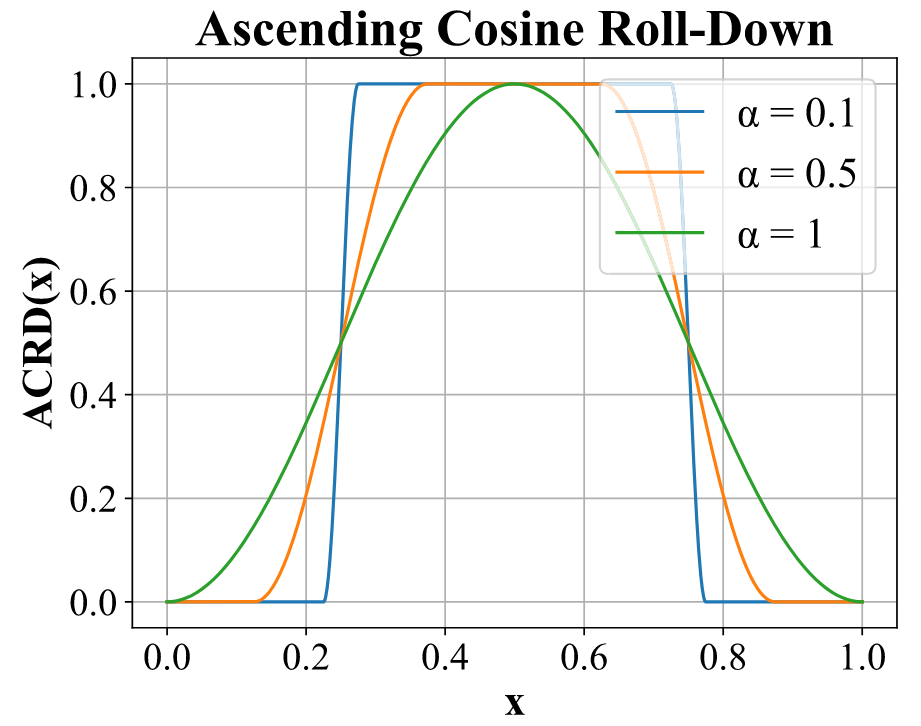

Saliency Oriented Bit Allocation Model

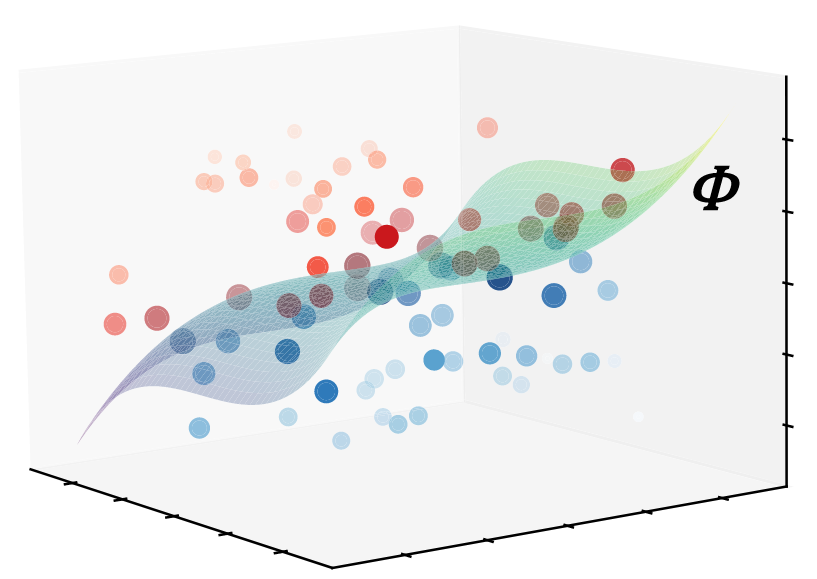

高维空间中的显著性分割边界,更靠近超平面的点(颜色更深、尺寸更大的点)对失真更敏感(压缩后易跨越超平面),需分配更多比特保障重建质量;远离超平面的点对失真更鲁棒,可少分配比特节省码率。

用显着性网络φ为每个像素计算特征空间中离超平面的距离 。

。

若w为负(蓝色),即认为在非ROI区域,若为正(红色)则为ROI区域。

归一化并对齐尺寸到特征图 。

。

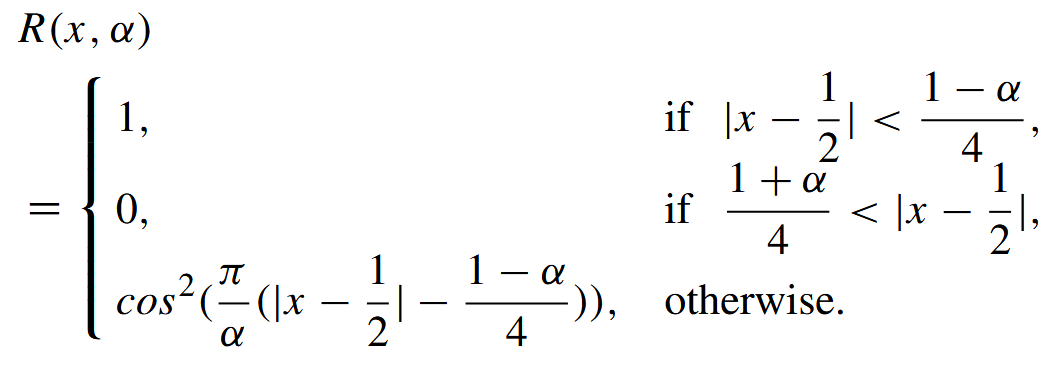

wnorm通过函数ACRD函数,生成比特分配图W。

接近0.5的值可以在ACRD函数后获得更大的位分配权重,相当于靠近超平面φ的那些较暗点。

超参数α控制“过渡带宽”,α越小,过渡越陡峭(对超平面附近点的比特分配更聚焦)。

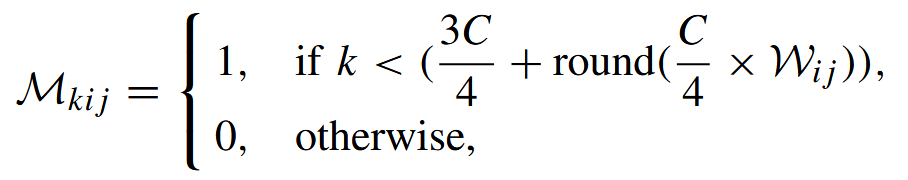

比特分配图W扩展为掩码M,与编码器提取的特征y尺寸匹配。基础层全为1,增强层由W的值四舍五入。

Double-Scale Entropy Module

编码器ga对输入图像计算潜在特征

然后对于特征y,分配成两部分,基础特征和增强特征。

掩码M进行特征过滤,对基础层无影响,增强层有变化 。

。

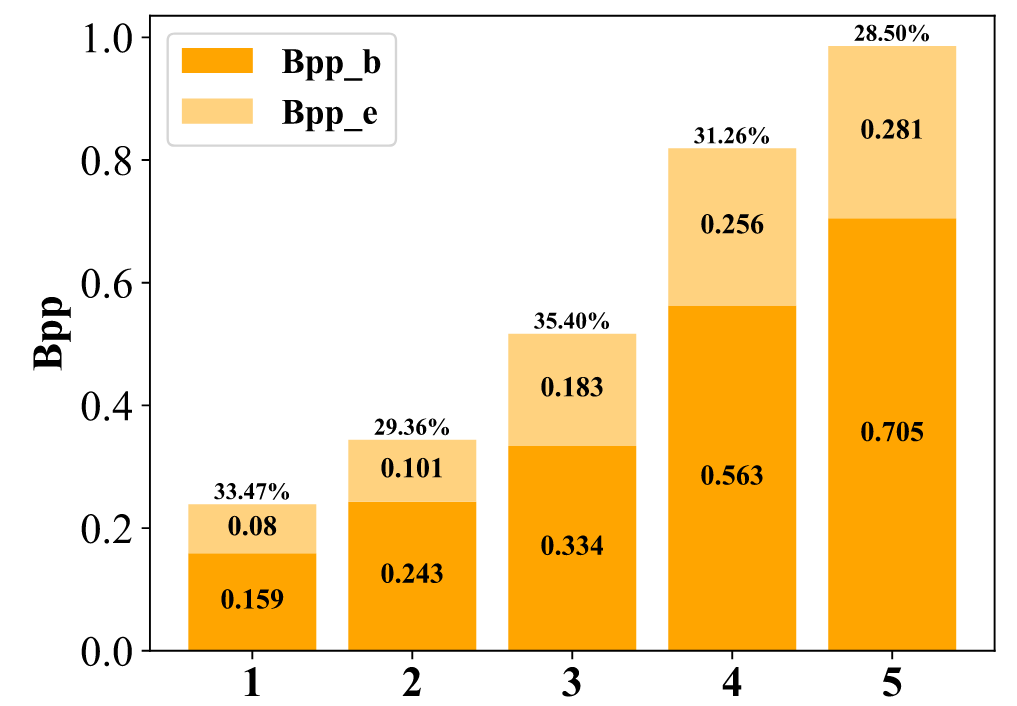

用两种不同的熵编码器分别计算bpp和熵编码特征。

再拼接起来进行解码。

Training Procedure

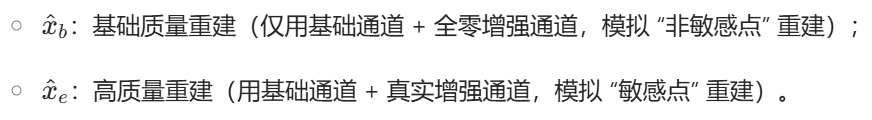

训练时不用显著性模型:让压缩模型对各类显著性分割网络具备通用性(不绑定特定分割模型)。

双质量重建训练:网络学习两种质量等级的图像重建(fe和fe0),模拟推理时增强通道按需保留的逻辑,实现局部失真控制(重要像素用更多增强通道,保障重建质量;非重要像素用基础通道,节省码率)。

得到两种尺度的latent特征 。

。

并进行解码得到两种重建结果 。

。

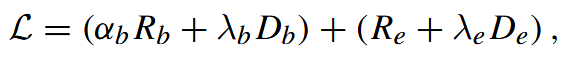

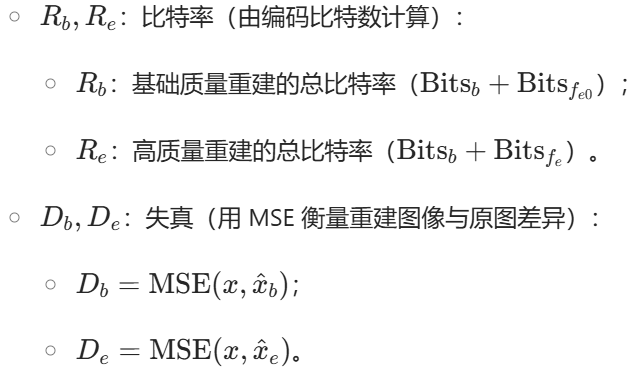

用双尺度R-D loss端到端训练整个压缩网络 。

。

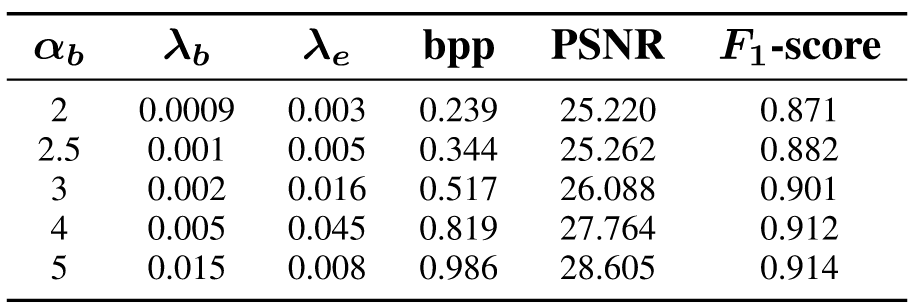

实验

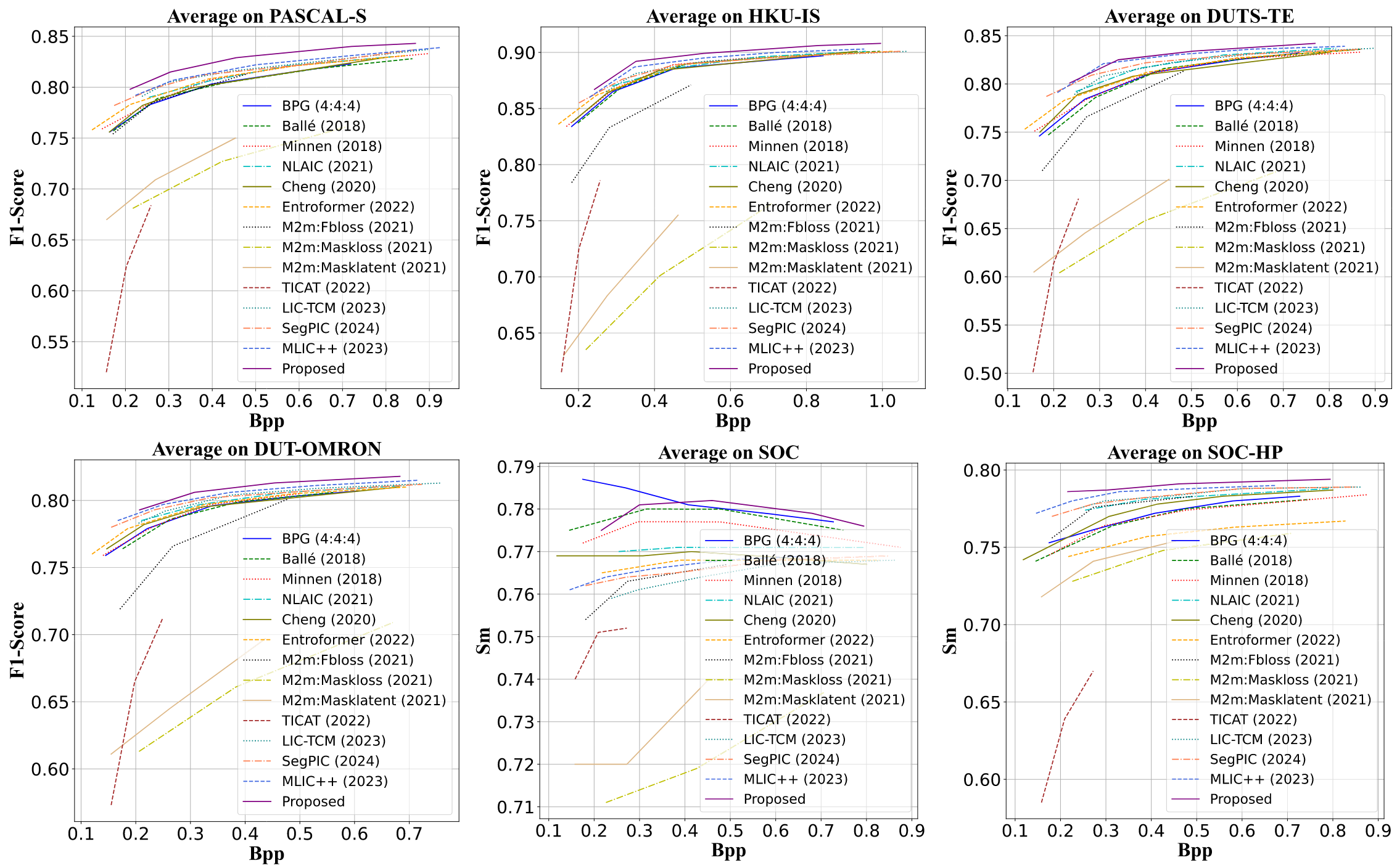

对显著性分割数据集进行压缩解压,然后在解码图像上进行显著性分割测评。

在F1-Score和Sm评估下,基本都优于其他压缩方法。

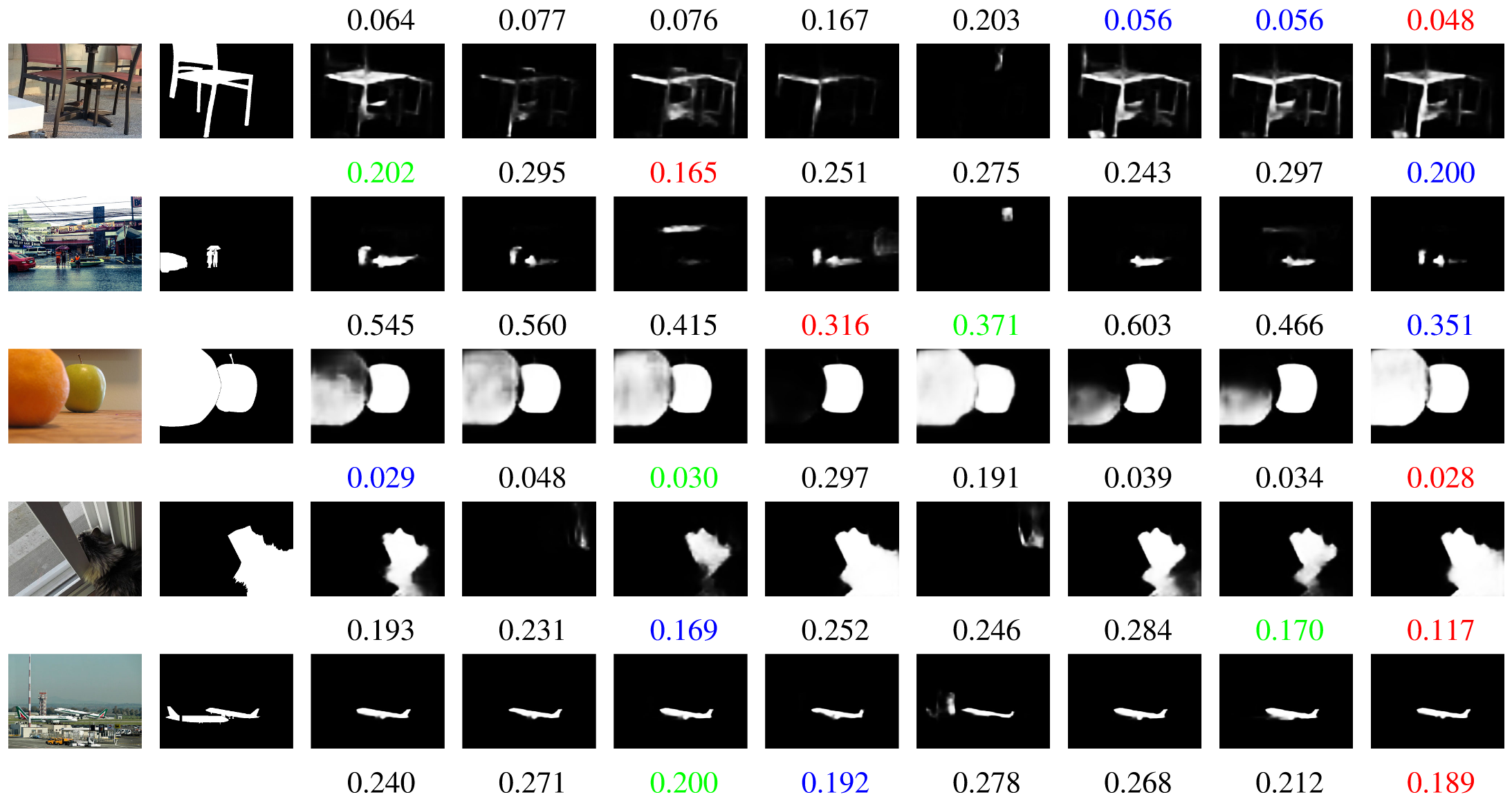

可视化结果,红蓝绿分别表示最好的三个结果。

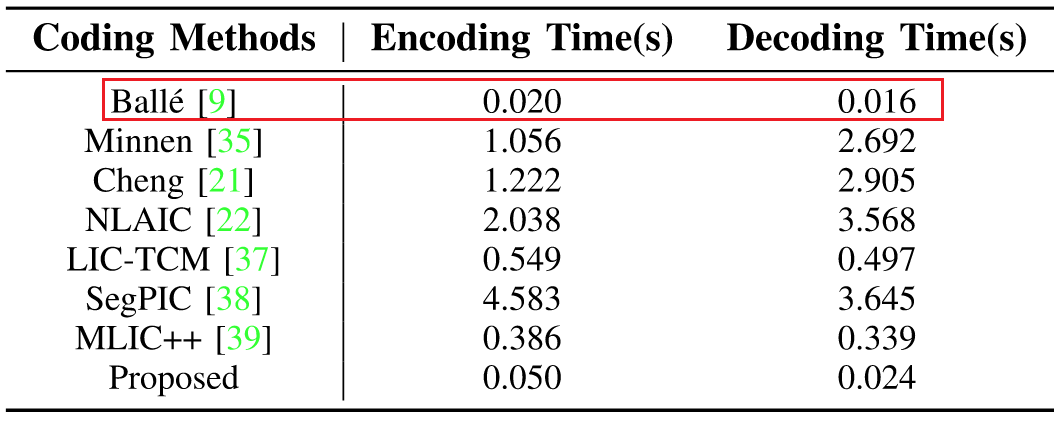

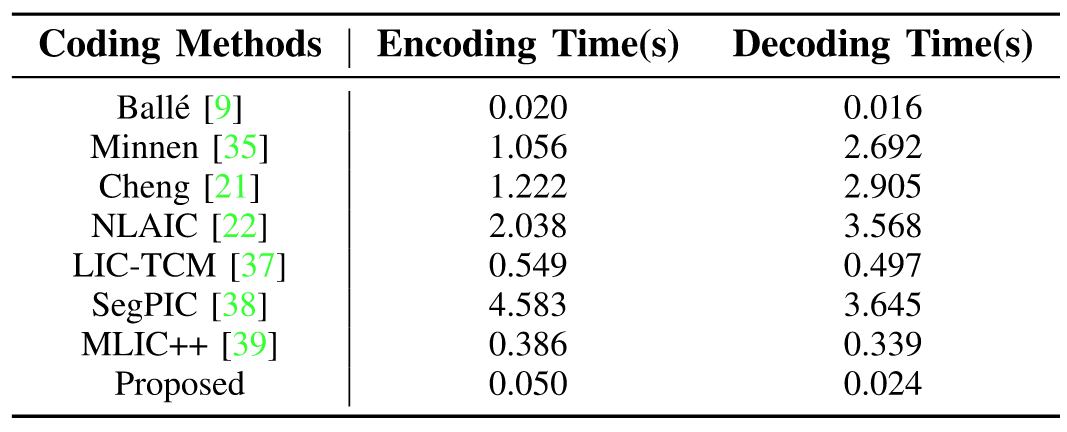

编码时间很快,比他快的效果没他好。

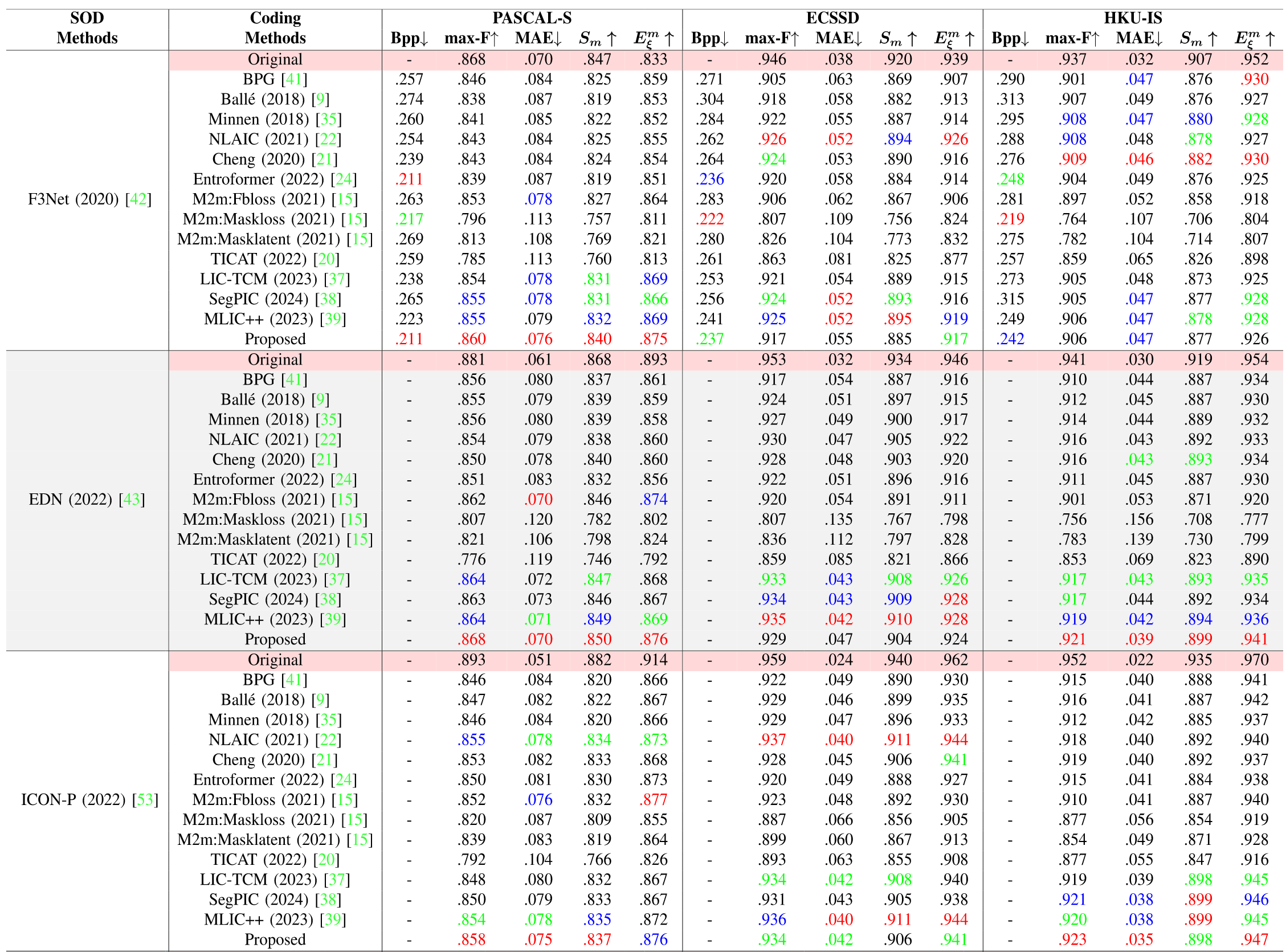

不同数据集使用压缩解压方法之后,使用显著性分割方法进行分割,提出的方法在多个数据集,多种分割方法上,都能达到不错的效果。

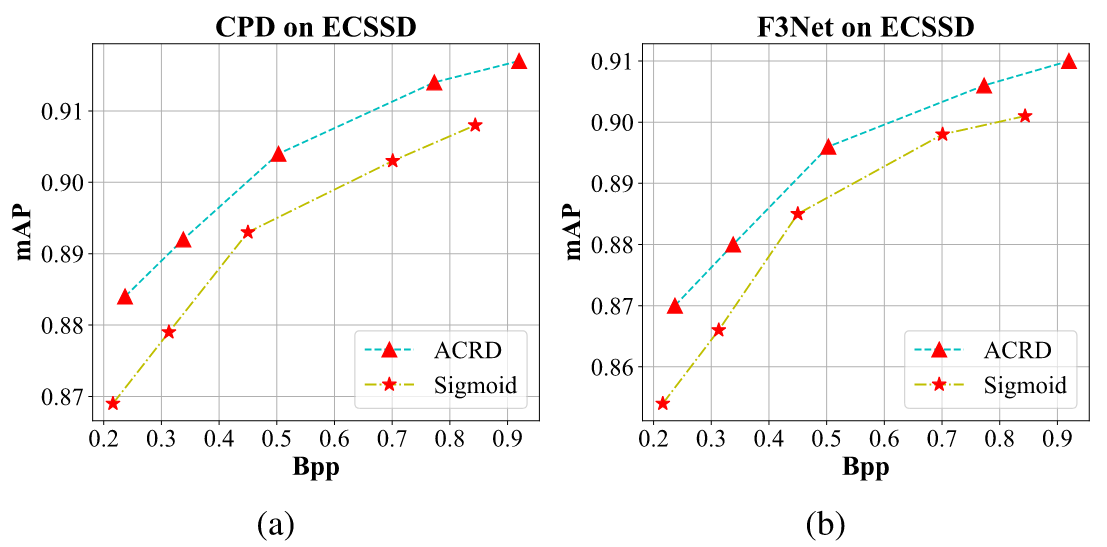

使用sigmoid替换ACRD的消融实验。

编码时间对比。