做网站不搭建本地环境网络推广网址

概述:

大型语言模型(LLM)展示了先进的功能和复杂的解决方案,使自然语言处理领域发生了革命性的变化。这些模型经过广泛的文本数据集训练,在文本生成、翻译、摘要和问答等任务中表现出色。尽管LLM具有强大的功能,但它可能并不总是与特定的任务或领域保持一致。

什么是LLM微调?

微调LLM涉及对预先存在的模型进行额外的训练,该模型之前使用较小的特定领域数据集从广泛的数据集中获取了模式和特征。在“LLM微调”的上下文中,LLM表示“大型语言模型”,例如OpenAI的GPT系列。这种方法具有重要意义,因为从头开始训练大型语言模型在计算能力和时间方面都是高度资源密集型的。利用嵌入预训练模型中的现有知识允许在显著减少数据和计算需求的情况下实现特定任务的高性能。

以下是LLM微调中涉及的一些关键步骤:

-

List item选择预训练模型:对于LLM微调,第一步是仔细选择符合我们所需架构和功能的基础预训练模型。预训练模型是在大量未标记数据的语料库上训练的通用模型。

-

收集相关数据集:然后我们需要收集与我们的任务相关的数据集。数据集应该以模型可以从中学习的方式进行标记或结构化。

-

预处理数据集:一旦数据集准备好,我们需要进行一些预处理以进行微调,方法是清理它,将其拆分为训练、验证和测试集,并确保它与我们想要微调的模型兼容。

-

微调:在选择了一个预训练的模型后,我们需要在预处理的相关数据集上对其进行微调,该数据集更适合手头的任务。我们将选择的数据集可能与特定的域或应用程序相关,从而允许模型针对该上下文进行调整和专门化。

-

特定任务的适应:在微调过程中,根据新的数据集调整模型的参数,帮助它更好地理解和生成与特定任务相关的内容。这个过程保留了在预训练期间获得的一般语言知识,同时根据目标领域的细微差别调整模型。

什么是LoRa?

LoRA是一种改进的微调方法,其中不是微调构成预训练的大型语言模型的权重矩阵的所有权重,而是微调近似于该较大矩阵的两个较小矩阵。这些矩阵构成了LoRA适配器。然后将这个经过微调的适配器加载到预先训练的模型中,并用于推理。

在针对特定任务或用例对LoRA进行微调后,结果是原始LLM不变,并且出现了相当小的“LoRA适配器”,通常表示原始LLM大小的个位数百分比(以MB而非GB为单位)。

在推理过程中,LoRA适配器必须与其原始LLM相结合。其优点在于许多LoRA适配器能够重用原始LLM,从而在处理多个任务和用例时降低总体内存需求。

什么是量化LoRA(QLoRA)?

QLoRA代表了LoRA的一种更具内存效率的迭代。QLoRA还通过将LoRA适配器(较小矩阵)的权重量化到较低精度(例如,4比特而不是8比特),使LoRA更进一步。这进一步减少了内存占用和存储需求。在QLoRA中,预训练的模型用量化的4位权重加载到GPU存储器中,而在LoRA中使用的是8位。尽管比特精度有所下降,QLoRA仍保持着与LoRA相当的有效性水平。

代码实现

依赖加载

from datasets import load_dataset

from transformers import (AutoModelForCausalLM,AutoTokenizer,BitsAndBytesConfig,HfArgumentParser,AutoTokenizer,TrainingArguments,Trainer,GenerationConfig

)

from tqdm import tqdm

from trl import SFTTrainer

import torch

import time

import pandas as pd

import numpy as np

from huggingface_hub import interpreter_login

from peft import LoraConfig, get_peft_model, prepare_model_for_kbit_training

from functools import partialimport os

#禁用权重和偏差

os.environ['WANDB_DISABLED']="true"

数据加载

huggingface_dataset_name = "neil-code/dialogsum-test"#“neil代码/对话和测试

dataset = load_dataset(huggingface_dataset_name)

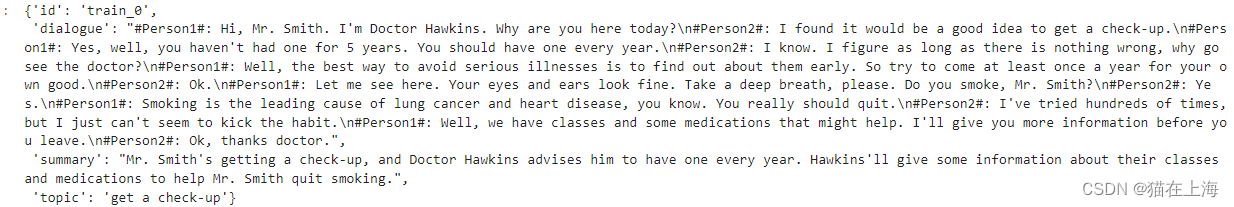

print(dataset['train'][0])

数据包含以下字段。

对话:对话的文本。

摘要:人类书写的对话摘要。

主题:人类书写的主题/对话的一行。

id:示例的唯一文件id。

加载模型

compute_dtype = getattr(torch, "float16")

bnb_config = BitsAndBytesConfig(load_in_4bit=True,bnb_4bit_quant_type='nf4',bnb_4bit_compute_dtype=compute_dtype,bnb_4bit_use_double_quant=False,)model_name=r'D:\临时模型\Meta-Llama-3-8B-Instruct'

device_map = {"": 0}

original_model = AutoModelForCausalLM.from_pretrained(model_name, device_map=device_map,quantization_config=bnb_config,trust_remote_code=True,use_auth_token=True)

BitsAndBytesConfig 为量化配置

-

List itemload_in_4bit=True:这个参数指定模型在加载时是否应该以4位量化的格式进行。这意味着模型的权重将使用4位精度来存储,从而减少模型的内存占用和加速推理过程。 -

bnb_4bit_quant_type='nf4':这个参数定义了用于量化的数值格式。在这里,‘nf4’ 代表 “Normal Float 4”,它是一种4位量化的浮点数格式,用于量化模型的权重。 -

bnb_4bit_compute_dtype=compute_dtype:这个参数指定了在推理时用于计算的数据类型。compute_dtype 是一个变量,应该在这段代码之前定义,它通常是一个类似于 torch.bfloat16 的数据类型,表示在计算期间使用的半精度浮点数格式。 -

bnb_4bit_use_double_quant=False:这个参数控制是否使用双量化技术。双量化是一种技术,它在量化过程中使用两个不同的量化表(lookup table)来提高精度。在这里,False 表示不使用双量化。

数据预处理

#prompt 工程

def create_prompt_formats(sample):"""格式化示例的各个字段('instruction','output')然后使用两个换行符将它们连接起来:参数sample:样本字典这里主要对数据添加一个prompt 用于给到大模型更好的格式规范,这里是模型效果提升的第一个关键点"""INTRO_BLURB = "Below is an instruction that describes a task. Write a response that appropriately completes the request."INSTRUCTION_KEY = "### Instruct: Summarize the below conversation."RESPONSE_KEY = "### Output:"END_KEY = "### End"blurb = f"\n{INTRO_BLURB}"instruction = f"{INSTRUCTION_KEY}"input_context = f"{sample['dialogue']}" if sample["dialogue"] else Noneresponse = f"{RESPONSE_KEY}\n{sample['summary']}"end = f"{END_KEY}"parts = [part for part in [blurb, instruction, input_context, response, end] if part]formatted_prompt = "\n\n".join(parts)sample["text"] = formatted_promptreturn sample#数据截断

def get_max_length(model):conf = model.configmax_length = Nonefor length_setting in ["n_positions", "max_position_embeddings", "seq_length"]:max_length = getattr(model.config, length_setting, None)if max_length:print(f"Found max lenth: {max_length}")breakif not max_length:max_length = 1024print(f"Using default max length: {max_length}")